Konténerezz okosan: Amazon ECS az AWS világában

- Erőforrás típus: PaaS

- Felhő szolgáltató: Amazon Web Services

- Angol név: Elastic Container Service

- Magyar név: Elastic Container Service

- Rövidített név (ha van ilyen): ECS

Ahogy egyre több alkalmazás kerül a felhőbe, úgy válik egyre fontosabbá a konténeresítés. Az Amazon ECS (Elastic Container Service) egy felügyelt konténer-orchesztrációs szolgáltatás, amely megkönnyíti a Docker konténerek futtatását és skálázását az AWS felhőben. Ez a cikk azoknak szól, akik most ismerkednek a konténer technológiákkal, és egy egyszerű, de erőteljes megoldást keresnek az alkalmazásaik futtatására.

Mi az Amazon ECS?

Az Amazon ECS egy olyan szolgáltatás, amely lehetővé teszi konténerek indítását és kezelését anélkül, hogy külön infrastruktúrát kellene kiépíteni vagy menedzselni. Teljes mértékben integrálódik más AWS szolgáltatásokkal, mint például az IAM (jogosultságkezelés), CloudWatch (monitorozás), és az ALB (Application Load Balancer).

Az ECS kétféleképpen használható:

- EC2 mód (IaaS): saját virtuális gépeken futtatott konténerekkel, ahol az infrastruktúra kezelése a felhasználó feladata.

- Fargate mód (PaaS): serverless megközelítés, ahol az AWS gondoskodik a háttér-infrastruktúráról. A felhasználónak csak a konténert kell megadnia.

Az Amazon ECS előnyei

- Felügyelt szolgáltatás: nem kell külön telepíteni vagy frissíteni konténer-orchesztrációs rendszereket.

- Fargate támogatás: a serverless konténerfuttatás révén nincs szükség szerverek kezelésére.

- Integráció AWS szolgáltatásokkal: könnyen összekapcsolható más szolgáltatásokkal (IAM, VPC, ALB, CloudWatch stb.).

- Skálázhatóság: automatikus skálázás és beépített magas rendelkezésre állás.

- Biztonság: IAM alapú hozzáférés-szabályozás és hálózati izoláció VPC-n belül.

Korlátai és kompromisszumok

- Csak AWS-en működik: nem multicloud vagy hybrid környezetre optimalizált.

- Kisebb ökoszisztéma, mint Kubernetes: kevesebb plugin és közösségi megoldás érhető el.

- ECS vs EKS: ha már van Kubernetes tapasztalatod, az EKS lehet jobb választás, de bonyolultabb is.

Amazon ECS vs Azure Container Instances (ACI)

| Jellemzők | Amazon ECS | Azure Container Instances |

|---|---|---|

| Szolgáltatás típusa | Orchesztráció (EC2 vagy Fargate) | Egyszerű konténerfuttatás |

| Skálázás | Automatikus, komplex | Alap skálázás |

| Hálózatkezelés | Teljes VPC integráció | Egyszerűbb, korlátozott |

| Hosszú távú futtatás | Ideális (pl. microservice-ekhez) | Rövid életű vagy egyszerű feladatokhoz |

| Integrációk | Szoros AWS-integráció | Alap Azure integráció |

| Orchestrator | ECS saját megoldása vagy Fargate | Nincs orchestrator |

Mikor érdemes az Amazon ECS-t választani?

Ha AWS ökoszisztémában dolgozol, és szeretnél stabil, jól skálázható és biztonságos konténeres megoldást, akkor az ECS remek választás. Különösen akkor ajánlott, ha mikroservice architektúrával dolgozol, vagy CI/CD pipeline-t szeretnél integrálni konténeres környezetbe.

Felhasználási példa

Képzeld el, hogy egy webshop backend API-t szeretnél futtatni konténerekben. A szolgáltatásokat – például a termékkezelést, kosár funkciókat és fizetési modulokat – külön konténerekbe szervezed. Az Amazon ECS segítségével ezeket Fargate-en futtathatod úgy, hogy nem kell szervereket kezelned. Az ALB segítségével terheléselosztást is beállíthatsz, a CloudWatch pedig biztosítja a monitorozást

Egyszerű webalkalmazás futtatása Amazon ECS-ben

Ha szeretnéd kipróbálni az Amazon ECS-t, íme egy alap példa, amellyel egy publikus Docker képből (pl. Nginx) indíthatsz el egy futó szolgáltatást:

1. Lépj be az AWS Console-ba

Nyisd meg az ECS konzolt és válaszd az „ECS” szolgáltatást.

2. Kattints a „Create Cluster” gombra

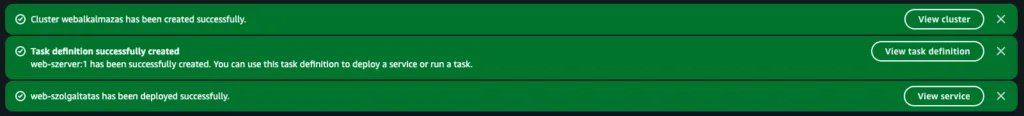

- Adj nevet a clusternek, pl.

webalkalmazas. - Válaszd a AWS Fargate (serverless) lehetőséget

- Kattints a „Create” gombra.

3. Hozz létre egy Task Definition-t

- Bal oldalon menj a „Task Definitions” menüpontra.

- Kattints a „Create new Task Definition” gombra.

- Task definition family mezőben adj meg egy nevet, pl. web-szerver

- Válaszd a „AWS Fargate” típust.

- Task role: válaszd a

ecsTaskExecutionRole-t (ha nincs, hozz létre az AWS útmutató alapján). - Add meg a következő konténer konfigurációt:

- Container name: nginx

- Image:

nginx - Port mappings: 80 → 80

- Kattints a „Create” gombra.

4. Hozz létre egy szolgáltatást (Service)

- Menj vissza a Clusterekhez, nyisd meg a

webalkalmazas - Válaszd a „Create” → „Service” opciót.

- Launch type: Fargate

- Task definition: válaszd ki az

web-szerverdefiníciót - Service name:

web-szolgaltatas - Number of tasks: 1

5. Hálózat és elérhetőség beállítása (opcionális)

- VPC: válaszd ki az alapértelmezett VPC-t (vagy sajátot, ha van).

- Subnet: válassz legalább egyet.

- Public IP: engedélyezd (Turned on), hogy elérhető legyen internetről is.

6. Indítsd el a szolgáltatást

Kattints a „Create” gombra. Néhány perc múlva a konténer futni fog.

7. Nyisd meg a böngésződben

Menj a futó Task részleteihez, és másold ki a hozzá rendelt publikus IP címet. (Clusters > webalkalmazas > Tasks > az ott szereplő task neve > Networking > Public IP)

Nyisd meg a böngésződben – meg kell jelennie az Nginx alapértelmezett kezdőoldalának.

Ezzel egy teljesen működő konténeres webalkalmazást indítottál el, szerverek kezelése nélkül. Látod, milyen egyszerű az első lépések megtétele az Amazon ECS-sel?

Összefoglalás

Az Amazon ECS egy jól integrált, rugalmas és skálázható megoldás azok számára, akik konténerekkel szeretnének dolgozni az AWS-en. Egyszerűbb, mint a Kubernetes, de elég erős nagyvállalati környezetekhez is. Ha AWS-t használsz, és stabil konténerkezelésre van szükséged, az ECS jó választás lehet.