Kubernetes telepítése és frissítése kubeadm használatával

A Minikube, K3s, Docker Desktop kiváló eszköz a Kubernetes alapjainak elsajátításához, de ha komolyabb környezetet szeretnél építeni, akkor a kubeadm az egyik legmegbízhatóbb módszer. A Kubernetes közösség hivatalosan is ezt a megközelítést támogatja, és folyamatosan fejleszti.

Most azt mutatom meg neked, hogyan hozhatsz létre egy Kubernetes alapú rendszert kubeadm segítségével, és hogyan frissítheted azt a jövőben.

Telepítés kubeadm segítségével

A kubeadm célja, hogy egyszerűen beüzemelhető Kubernetes alapú rendszert állítson elő. A telepítés több lépésből áll, melyek külön konfigurációs lehetőségeket is kínálnak.

Alapvető lépések:

- A vezérlőcsomópont inicializálása (első tag)

Akubeadm initparancs segítségével elindítod a rendszer felállítását. Ez a parancs létrehoz egy token-t és egy SHA256 hash-t, amelyek szükségesek ahhoz, hogy más gépek is csatlakozzanak a control plane-hez (vezérlő). - Hálózati komponens telepítése

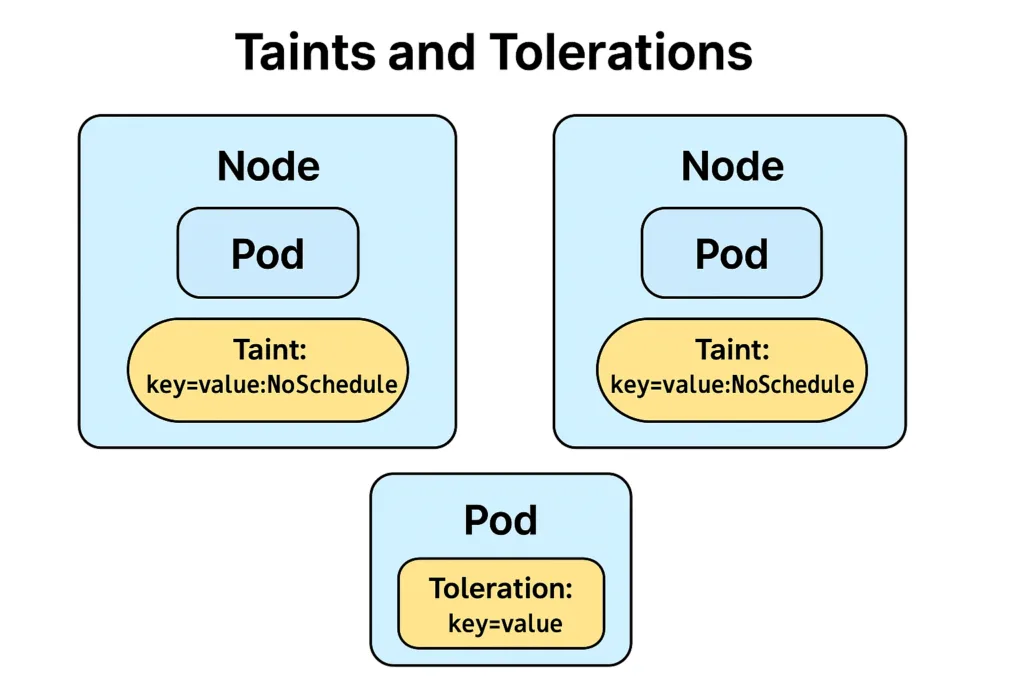

A Kubernetes alaptelepítés nem tartalmaz hálózati megoldást. Választanod kell egy CNI (Container Network Interface) bővítményt, mint például Calico vagy Flannel. A telepítés általában egy YAML manifest segítségével történik, amelyetkubectl applyparanccsal lehet használni. - További csomópontok csatlakoztatása

Akubeadm joinparancs segítségével munkagépeket vagy másodlagos vezérlőcsomópontokat adhatsz hozzá a meglévő control plane-hez. Ehhez az előzőleg létrehozott token és hash szükséges.

Miután a rendszer összeállt, már használatra kész, és elindíthatod rajta az első szolgáltatásaidat és pod-jaidat. 🌟

Itt megtalálod a hivatalos dokumentációt is: Creating a cluster with kubeadm

Frissítés kubeadm-mel

A rendszeres frissítés fontos a biztonság és stabilitás fenntartása érdekében. A kubeadm támogatja a vezérelt frissítést, amely megőrzi a korábbi állapotot és minimalizálja a leállási időt.

Főbb lépések:

- Csomagfrissítés

Frissítsd a rendszereden akubeadm,kubeletéskubectlkomponenseket a legújabb verzióra a csomagkezelő segítségével. - Frissítési terv ellenőrzése

Akubeadm upgrade planparanccsal ellenőrizheted, hogy a jelenlegi verzióhoz képest milyen új verziók érhetők el, és hogy a rendszered frissíthető-e. - Control plane előkészítése

A vezérlőcsomópontot „le kell üríteni” (kubectl drain), hogy ne fusson rajta semmilyen pod a frissítés alatt. - Frissítés alkalmazása

Akubeadm upgrade applysegítségével végrehajthatod a frissítést. Ez automatikusan módosítja a szükséges konfigurációkat. - Eltérések előnézete (opcionális)

Akubeadm upgrade diffhasonló a dry-run működéshez, vagyis megmutatja, milyen változások történnének. - Node-ok konfigurációja

Akubeadm upgrade nodesegítségével frissítheted a kubelet konfigurációját minden csatlakozott gépen. - Control plane újranyitása

Akubectl uncordonparanccsal újra engedélyezheted, hogy a vezérlőcsomóponton pod-ok fussonak.

Itt megtalálod a hivatalos dokumentációt is: Upgrading kubeadm clusters

Összefoglalva, a kubeadm ideális eszköz azok számára, akik gyorsan és hatékonyan szeretnének egy stabil Kubernetes környezetet létrehozni, amely hosszú távon is jól karbantartható. A megfelelő lépések betartásával biztonságosan telepíthető és frissíthető egy Kubernetes alapú rendszer. A folyamat jól dokumentált, a hibalehetőségek pedig minimálisra csökkenthetők, ha követjük az ajánlott gyakorlatokat.

Legközelebb bemutatom, az egyes hálózati megoldásokat, amelyet a Kubernetes cluster-eden belül használhatsz. 🛰️