Így tanul meg az MI látni: Vision Language Modellek

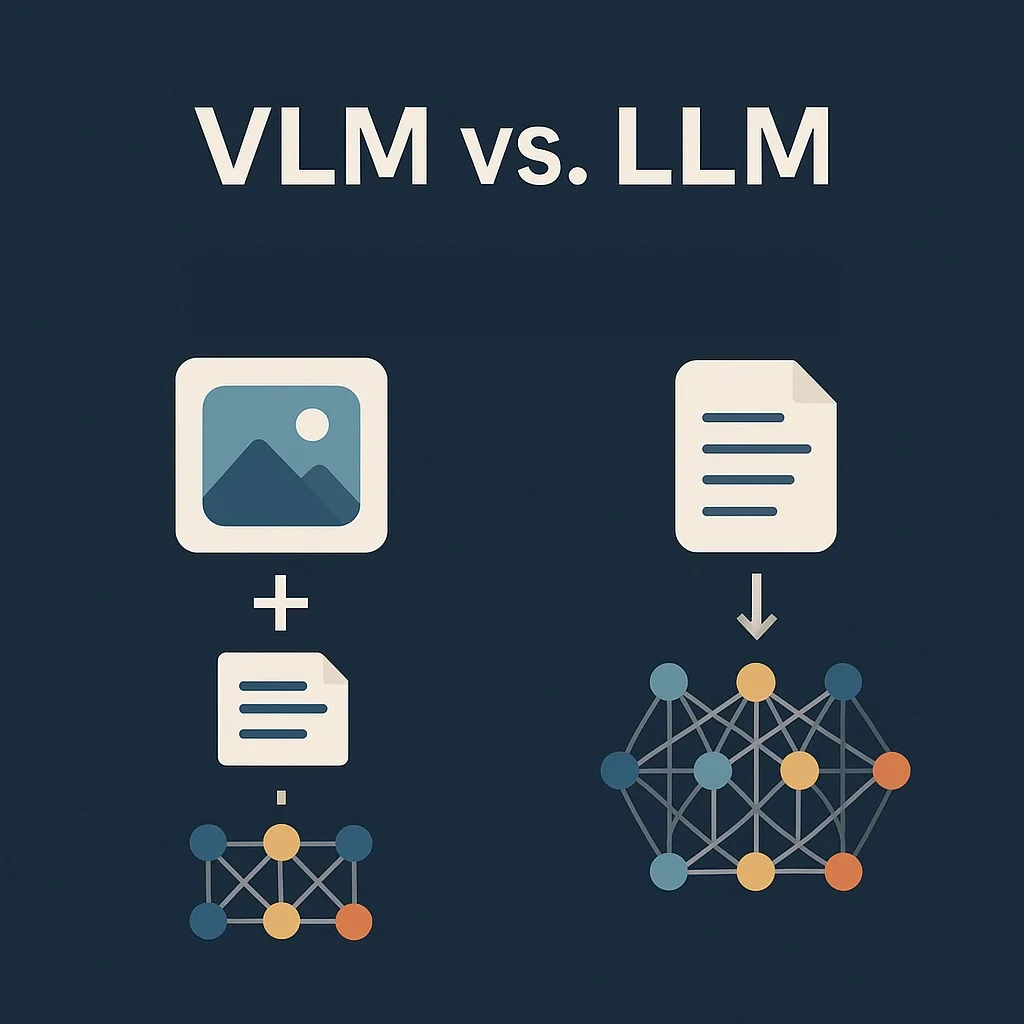

A mesterséges intelligencia (MI) világa folyamatosan látványos fejlődést mutat. Az egyik legérdekesebb irány a VLM, vagyis a Vision Language Model technológia. Ezek a modellek nemcsak szövegeket értenek meg, mint a hagyományos nyelvi modellek (LLM-ek), hanem képeket is képesek értelmezni.

Koncepció – Mit jelent a VLM?

A VLM (Vision Language Model) olyan mesterséges intelligenciát takar, amely egyszerre képes szöveges és képi információt értelmezni. Ez új szintre emeli az MI lehetőségeit, hiszen az eddigi rendszerek vagy csak szöveggel, vagy csak képpel dolgoztak. A VLM viszont multimodális: a kettőt egyszerre kezeli.

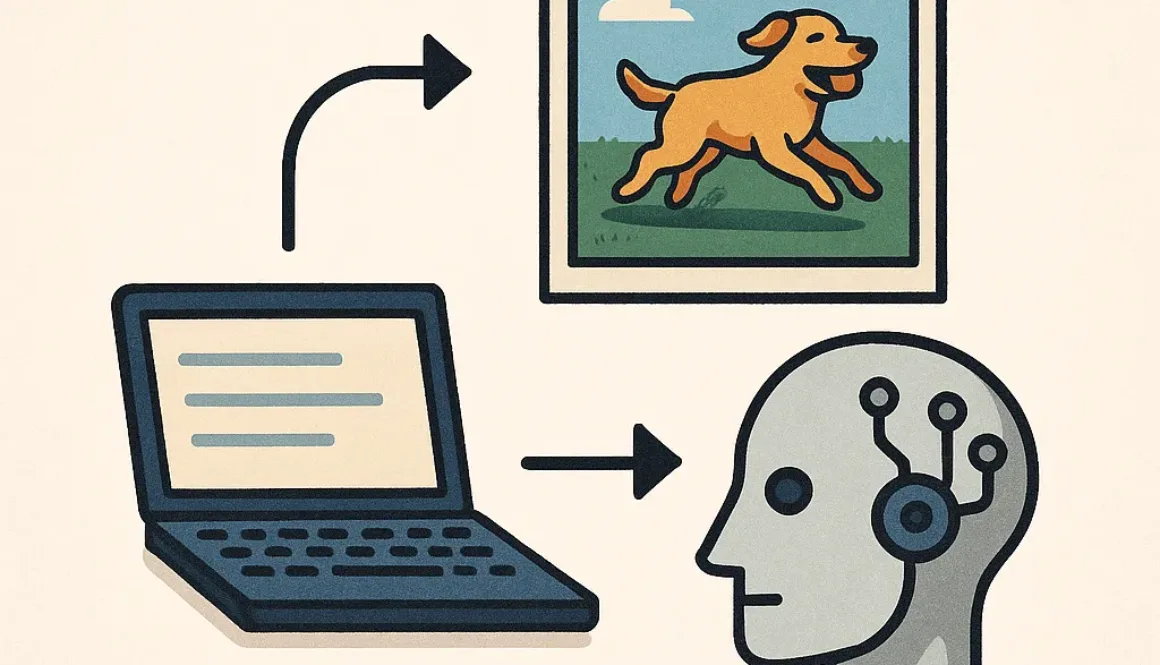

Hasonlat – Mintha egy gyerek könyvből tanulna

Képzeljünk el egy kisgyermeket, aki egy képeskönyvet nézeget. Megnézi a képet, majd a szöveg alapján próbálja megérteni, mi történik. A Vision Language Model ugyanezt teszi: képeket lát és szövegeket olvas, majd ezekből közösen von le következtetéseket.

Hol hasznos ez a technológia?

- Egészségügy: orvosi képek (pl. röntgen) értelmezése, diagnosztikai támogatás.

- Oktatás: multimodális tananyag-elemzés, képekhez kapcsolódó tartalomgenerálás.

- Kereskedelem: termékek automatikus leírása képek alapján.

- Segítő technológia: látássérülteknek képleírás generálása.

- Robotika: képfeldolgozáson alapuló döntéshozatal.

- Dokumentumfeldolgozás: szkennelt számlák, bizonylatok elemzése.

- Grafikon- és diagramértelmezés: üzleti jelentések automatikus értelmezése.

Hogyan működik?

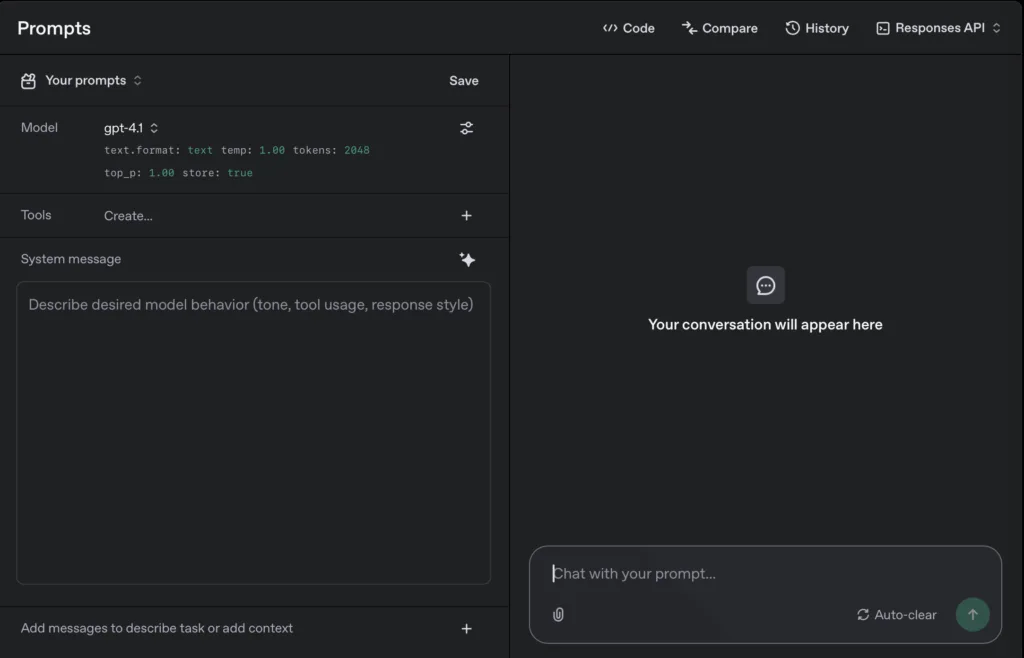

A hagyományos LLM (Large Language Model), mint például a GPT, kizárólag szöveggel tud dolgozni. Amikor beírunk egy kérdést vagy dokumentumot, azt a modell token-ekre bontja – ezek a nyelv számszerű leképezései. Az LLM ezeket a token-eket ú.n. figyelmi mechanizmusok segítségével elemzi, feltárja a közöttük lévő összefüggéseket, majd ezek alapján állít elő egy új szöveges választ.

De mi van akkor, ha a dokumentum képeket tartalmaz? Bonyolult grafikon? Szkennelt ábra? Egyhagyományos LLM nem tud mit kezdeni ezekkel. Itt lép be a képbe a VLM.

A VLM úgy működik, hogy egy új modult vezet be: a vision encoder-t. Ez a rész nem szavakat, hanem képeket dolgoz fel. A képből kinyeri a fontos jellemzőket – formákat, textúrákat, éleket, viszonyokat – és ezt egy úgynevezett feature vector-rá alakítja, vagyis egy tömör, számszerű leképezéssé.

Ezek azonban még nem kompatibilisek az LLM szöveges token-jeivel, ezért egy projektor nevű modul átalakítja őket úgynevezett kép-token-ekké. Most már van szöveg-token-ünk és kép-token-ünk, és ezeket együtt tudja kezelni az LLM. A modell ezek után együttesen értelmezi a szöveget és a képet, és ezek összefüggése alapján ad választ.

Például:

- VQA (Visual Question Answering): Megmutatunk egy képet egy forgalmas utcáról, és megkérdezzük: „Mi történik itt?” A válasz lehet: „Egy piros lámpánál várakozó autó, gyalogosok átkelnek.”

- Képaláírás generálás: Egy kutyát ábrázoló képre a válasz: „Golden retriever labdát kerget egy parkban.”

- Számlák vagy bizonylatok feldolgozása: Szkennelt PDF beolvasása után a modell képes kiolvasni a szöveget, struktúrába rendezni, sőt, összefoglalni a lényeget.

- Grafikon-elemzés: Egy pénzügyi jelentésben található diagram alapján kérdezhetjük: „Mi a bevételi trend?” – és a modell választ ad rá.

Miért újdonság?

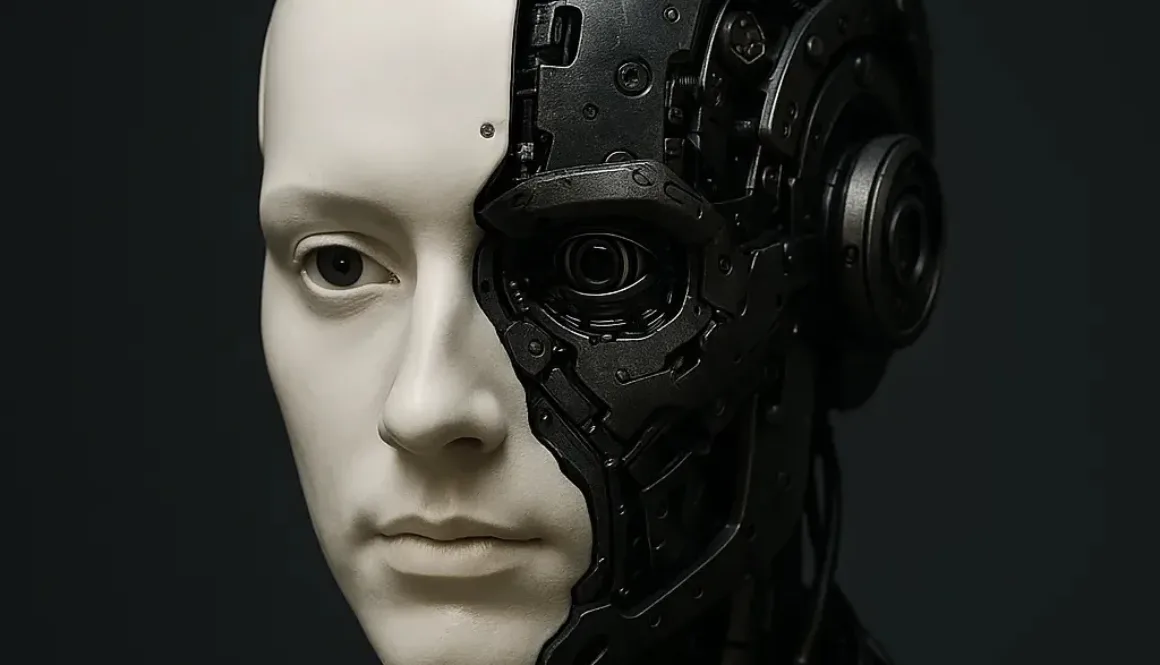

A LLM-ek már régóta képesek értelmes szöveget generálni, de teljesen vakok voltak a képi információkra. A VLM az első valódi megoldás arra, hogy a mesterséges intelligencia ne csak olvasson, hanem „lásson” is. Ez új távlatokat nyit, hiszen az emberi gondolkodás sem csak szavakból áll – képeket, helyzeteket, kontextusokat is értelmezünk.

A technológia azonban nem hibátlan:

- A képek feldolgozása sokkal erőforrásigényesebb, mint a szövegé.

- A modell hallucinálhat – azaz olyan válaszokat adhat, amelyek jól hangzanak, de nem igazak, mivel statisztikai minták alapján következtet.

- Bias (torzítás) is jelen lehet: ha a tanítóadatok túlnyomórészt nyugati kultúrkörből származnak, más régiók képeit félreértelmezheti.

Miért lesz hasznos a jövőben?

A jövő mesterséges intelligenciája egyre inkább hasonlít majd az emberi gondolkodásra. A VLM-ek ezt a folyamatot gyorsítják fel, hiszen már nemcsak beszélnek, hanem látnak is. Ezáltal sokkal hatékonyabban alkalmazhatók például:

- összetett döntéshozatalban,

- automatizált dokumentumfeldolgozásban,

- vagy akár vizuális tanulási rendszerekben.

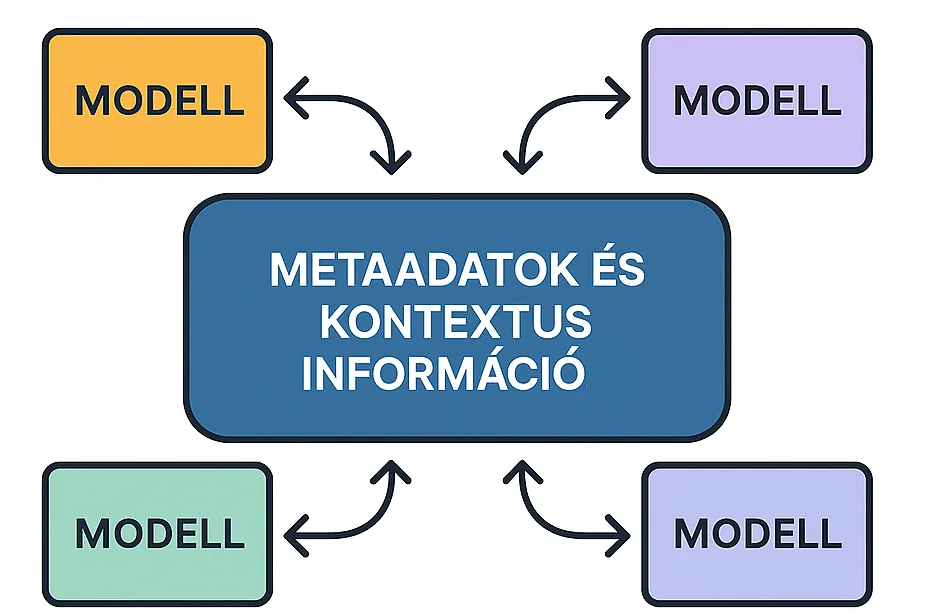

VLM vs. LLM – Hasonlóságok és különbségek

| LLM (Large Language Model) | VLM (Vision Language Model) | |

|---|---|---|

| Alap | Nagy nyelvi modell | Nagy nyelvi modell + vizuális feldolgozó modulok |

| Bemenet | Csak szöveg | Szöveg és kép |

| Képességek | Szövegalapú válaszadás, szövegírás | Szövegalkotás képi információk alapján is |

| Kontextus | Csak nyelvi összefüggések értelmezése | Nyelvi és vizuális kontextus együttes értelmezése |

| Felépítés | Tokenizálás → nyelvi feldolgozás | Kép → feature vector → kép-token → közös feldolgozás |

| Modulok | Csak nyelvi feldolgozás | Vision encoder, projektor, nyelvi feldolgozás együtt |

| Használat | Dokumentumok, csevegés, szövegértés | Képaláírás, VQA, dokumentum-elemzés, grafikon-értelmezés |

Összefoglalás

A Vision Language Model nem egy forradalmi újdonság, sokkal inkább a mesterséges intelligencia természetes fejlődési lépése. Az eddigi nyelvi és vizuális modellek ötvözésével a VLM-ek lehetővé teszik, hogy az MI ne csak olvassa, hanem értelmezze is a képi világot.

Ez új lehetőségeket nyit például dokumentumfeldolgozásban, oktatásban vagy egészségügyben – olyan területeken, ahol eddig emberi látásra és megértésre volt szükség. Bár a technológia még fejlődik, az irány egyértelmű: a mesterséges intelligencia egyre közelebb kerül ahhoz, hogy több érzékszervhez hasonlóan működjön – és ezzel valóban új minőséget képviseljen.

Te hogyan hasznosítanád ezt a tudást a saját területeden?