AWS EBS alapok: SSD merevlemez virtuális gépekhez

Amikor először léptél be a felhő világába – akár csak kísérletezőként –, elképzelted talán, hogy a virtuális gépeken minden „mindent a semmiből” kezdünk, és amikor ez a gép eltűnik, minden adat is vele. Nos, az Amazon Elastic Compute Cloud (EC2) kezdeti időszakában ez így is volt sokszor: az „instance store” típusú tárolók a virtuális gép életciklusához kötődtek.

Ma viszont, amikor már alkalmazás-monitoringról, mikroszolgáltatásokról és autoscaling-ről beszélünk, ott van az Amazon Elastic Block Store (EBS) – a felhőben tárolt merevlemez-megoldás.

Ha korábban már foglalkoztál azzal, hogy naplókat, metrikákat vagy adatokat felhőben kell megőrizni, akkor az EBS adja ehhez az alapot: megbízható, gyors és rugalmas tároló-eszköz. Most nézzük meg részletesen – kezdők számára is – mit jelent az EBS volume, mik az előnyei, mire használható és milyen korlátai vannak.

Mi az EBS Volume?

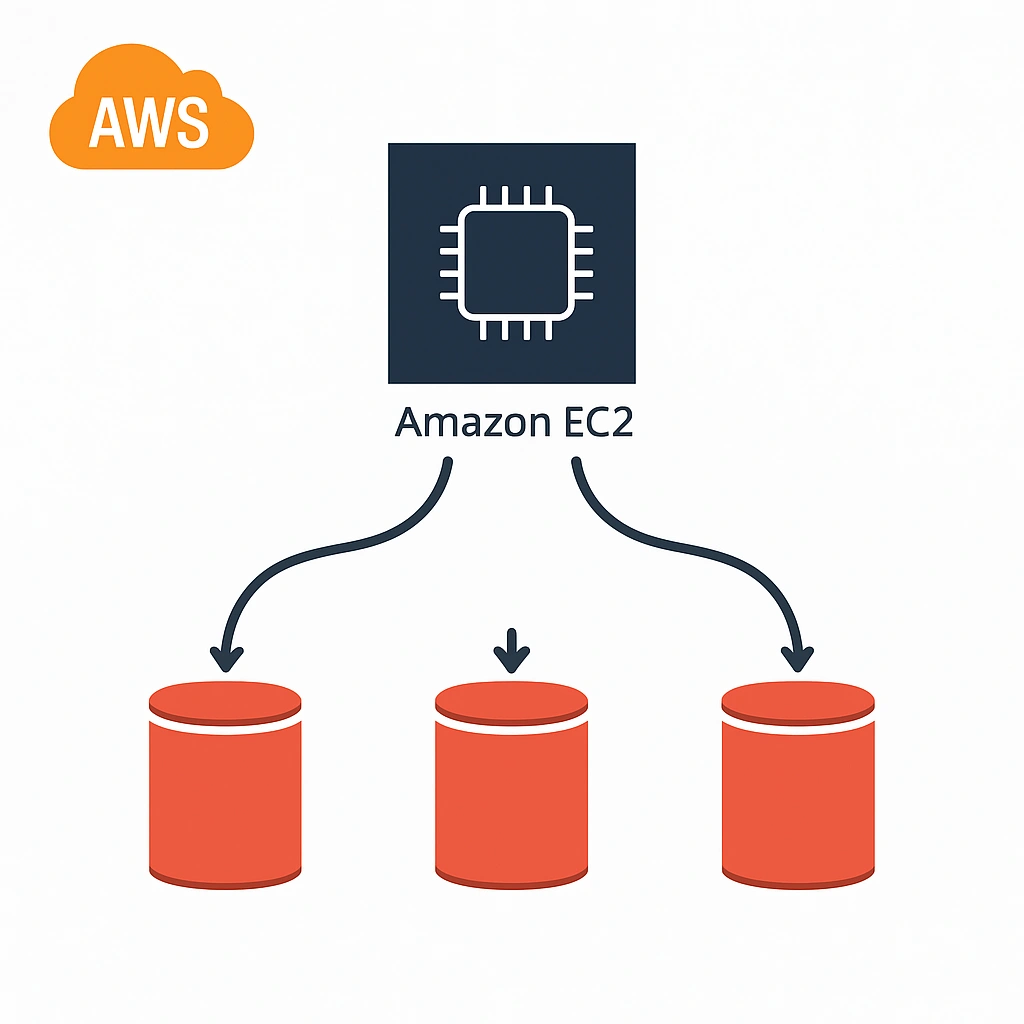

Az EBS volume egy virtuális blokkszintű tárolóegység, amelyet az Amazon EBS-en belül hozol létre, és amelyet egy EC2 példányhoz csatolhatsz, mintha egy fizikai merevlemezt adnál hozzá.

Fő jellemzői:

- Az EBS volume az EC2 példánytól függetlenül is megőrzi az adatokat – tehát a tárolt információ nem vész el, ha a gépet leállítod vagy újraindítod.

- Minden volume egy adott Availability Zone-hoz tartozik, és csak ott használható.

- A felhasználó formázhatja, mountolhatja, olvashat és írhat rá, ugyanúgy, mint egy helyi meghajtóra.

Virtuális blokkszintű tárolóegység

Olyan felhőben létrehozott háttértár, amely az operációs rendszer számára úgy viselkedik, mint egy hagyományos merevlemez. Az adatokat blokkokra osztva tárolja és kezeli, így az alkalmazások közvetlenül olvashatják vagy írhatják ezeket a blokkokat.

A „virtuális” jelző azt jelenti, hogy nem egy konkrét fizikai lemezen, hanem a szolgáltató (például az AWS) elosztott tárolórendszerében található az adat — a felhasználó számára mégis egyetlen logikai meghajtónak látszik.

Hogyan működik a háttérben?

Bár az EBS-t úgy látjuk, mintha egy „saját” merevlemezünk lenne a felhőben, valójában nem egyetlen fizikai lemezről van szó. Az EBS mögött az Amazon belső, elosztott tárolórendszere dolgozik, amely több fizikai háttértáron, különböző szervereken tárolja és replikálja az adatokat.

Ez a felhasználó számára átlátszó: a blokkeszköz úgy viselkedik, mint egy hagyományos disk, de a valóságban több háttértár és redundáns adatmásolat biztosítja az állandóságot és a teljesítményt.

Ez a megoldás teszi lehetővé, hogy:

- az adatok automatikusan védve legyenek hardverhiba esetén,

- egyetlen lemezhiba ne okozzon adatvesztést,

- az EBS skálázni tudja a háttérkapacitást emberi beavatkozás nélkül.

Tehát az EBS nem egy konkrét „disk”, hanem egy blokkszintű, hálózaton keresztül elérhető tárolószolgáltatás, amelyet az AWS menedzsel helyetted.

Erősségek és lehetőségek

Megbízhatóság és tartósság

Az EBS automatikusan több alrendszer között replikálja az adatokat, így egy hardverhiba sem okoz adatvesztést. Ha az EC2 példány leáll, az EBS adatai akkor is megmaradnak (amennyiben a beállítás ezt engedi).

Skálázhatóság és rugalmasság

Ennek egyik legnagyobb előnye, hogy a méretét, típusát vagy IOPS-értékét akár működés közben is módosíthatod.

Az AWS több típusú EBS volument kínál: SSD-alapú (pl. gp2, gp3, io1, io2) és HDD-alapú (pl. st1, sc1) változatokat. Az előbbiek gyors, tranzakciós feladatokra, az utóbbiak nagy adatátviteli igényű munkákra ideálisak.

Biztonság és mentés

Az EBS snapshot segítségével pillanatképet készíthetsz a volume-ról, amelyet később visszaállíthatsz, vagy akár más régióba is átmásolhatsz.

Támogatja a titkosítást is: a KMS-kulcsokkal titkosíthatók a volume-ok és snapshotok, így az adatok védettek mind tárolás, mind átvitel közben.

Típusok

Az Amazon EBS (Elastic Block Store) többféle volume típust kínál, amelyek különböző teljesítmény- és költségigényekhez igazodnak. Ezeket alapvetően két fő kategóriába soroljuk: SSD-alapú (alacsony késleltetésű, tranzakciós műveletekre) és HDD-alapú (nagy áteresztésű, szekvenciális feldolgozásra) kötetekre.

SSD-alapú volume-ok (alacsony késleltetésű, gyors műveletekhez)

Ezek ideálisak operációs rendszerekhez, adatbázisokhoz, webalkalmazásokhoz és más tranzakciós jellegű munkákhoz.

| Típus | Jellemző | Ideális felhasználás | Teljesítmény / IOPS | Árszint |

|---|---|---|---|---|

| gp3 (General Purpose SSD, új generáció) | Alapértelmezett típus. Fix áron magasabb teljesítményt ad, mint a gp2. | Általános célú alkalmazások, web- és adatbázisszerverek. | Alap: 3 000 IOPS, 125 MB/s; max: 16 000 IOPS, 1 000 MB/s | Költséghatékony |

| gp2 (General Purpose SSD, régi generáció) | Régebbi típus, teljesítmény a mérettől függ. | Olyan rendszerek, ahol nem kritikus a skálázhatóság. | 3 IOPS / GB (max 16 000 IOPS) | Közepes |

| io1 (Provisioned IOPS SSD) | Nagy teljesítmény, garantált IOPS. | Kritikus adatbázisok, pl. Oracle, SAP HANA. | 100 – 64 000 IOPS | Magas |

| io2 (Provisioned IOPS SSD, új generáció) | Jobb tartósság (99,999%) és magasabb IOPS-arány. | Nagyvállalati adatbázisok, alacsony késleltetést igénylő alkalmazások. | 100 – 256 000 IOPS | Magas |

HDD-alapú volume-ok (nagy adatátvitel, olcsóbb)

Ezeket főként nagy mennyiségű, szekvenciális adat feldolgozására használják, például logok, biztonsági mentések, adatarchívumok esetén.

| Típus | Jellemző | Ideális felhasználás | Átviteli sebesség | Árszint |

|---|---|---|---|---|

| st1 (Throughput Optimized HDD) | Nagy áteresztés, költséghatékony tárolás. | Nagy adatfolyamot kezelő rendszerek (pl. log-elemzés, Big Data). | Max 500 MB/s | Alacsony |

| sc1 (Cold HDD) | Archív, ritkán elérhető adatokhoz. | Biztonsági mentések, ritka hozzáférésű adatok. | Max 250 MB/s | Legolcsóbb |

Összehasonlítás röviden

| Kategória | Típusok | Teljesítmény | Költség | Tartósság | Fő cél |

|---|---|---|---|---|---|

| SSD | gp3, gp2, io1, io2 | Nagyon gyors | Közepes–magas | 99,8–99,999% | Adatbázis, OS, tranzakciók |

| HDD | st1, sc1 | Mérsékelt | Alacsony | 99,8% | Archívum, log, backup |

Egyszerű példák

- Webalkalmazás: van egy EC2-n futó weboldalad, amely adatbázist használ. Külön EBS volument csatolsz az adatbázishoz, így az adatok nem vesznek el akkor sem, ha a példányt újratelepíted.

- Adatfeldolgozás: egy log-gyűjtő rendszer nagy mennyiségű adatot olvas és ír. Ilyenkor érdemes nagy áteresztésű, HDD-alapú (pl. st1) EBS-t választani.

Szolgáltatási szint (SLA)

Az AWS az EBS-re 99,999%-os tartóssági és 99,99%-os rendelkezésre állási szintet vállal.

Ez a gyakorlatban azt jelenti, hogy évente mindössze néhány percnyi szolgáltatáskiesés valószínű.

A tartóssági garancia kifejezetten magas: az AWS belső infrastruktúrája több adatmásolatot tart, így az adatok elvesztésének esélye rendkívül alacsony.

Ugyanakkor ez nem jelenti azt, hogy nincs szükség mentésre – az AWS maga is javasolja a rendszeres snapshot-készítést, hiszen az SLA csak a szolgáltatás elérhetőségére és megbízhatóságára, nem pedig az emberi hibákból eredő adatvesztésre vonatkozik.

Hogyan segíti a cégeket és felhasználókat

- Gyorsan növekvő szoftvercég az EBS-t használhatja skálázható háttértárként: ha nő az ügyfélbázis, a volume-ot egyszerűen bővíthetik vagy nagyobb teljesítményűre cserélhetik, leállás nélkül.

- Egy startup az alacsonyabb árú, gp3 típusú volume-val indíthatja el alkalmazását, így kezdetben nem kell túlfizetnie a tárolásért.

- Kisvállalkozás, amely webáruházat működtet az AWS-en, EBS-t használhat a vásárlói adatok és képek biztonságos, tartós tárolására.

Korlátok és megfontolások

- Egy EBS volume csak abban az Availability Zone-ban használható, ahol létrejött.

- A díjazás méret- és típusfüggő, és a lefoglalt kapacitás után fizetsz, nem a tényleges használat után.

- A teljesítményt a választott volume-típus és az EC2 példány típusa együtt határozza meg.

- Az EBS általában csak egy példányhoz csatolható; több géphez csak speciális beállításokkal.

- Az adott régió kiesése esetén a volume is elérhetetlenné válhat, ezért érdemes snapshotokkal biztonsági mentést készíteni.

Összegzés

Az AWS EBS volume egy megbízható, tartós és skálázható blokktárolási megoldás, amely ideális választás virtuális gépekhez. Segítségével az adatok függetlenek maradnak az EC2 példány életciklusától, könnyen bővíthetők, és egyszerűen menthetők snapshotokkal.

Erősségei közé tartozik a stabilitás, a gyors adatkezelés, a rugalmas méretezhetőség és a titkosítási lehetőség. Ugyanakkor érdemes figyelni az elérhetőségi zónák korlátaira és a költségek optimalizálására.

Ha a felhőben adatbázist, webalkalmazást vagy akár nagy adatfeldolgozó rendszert építesz, az EBS az egyik legfontosabb építőkockád lesz – megbízható, mint egy jó merevlemez, csak épp a felhőben.