Újdonságok: 2026 elején megjelent AI modellek és agentek

A mesterséges intelligencia világában folyamatos a pörgés és a változás. Rendszeresen jelennek meg az egyes nagy nyelvi modellek (LLM) újabb, frissített — de nem feltétlenül jobb — verziói. Most, hogy túl vagyunk januáron, érdemes egy pillanatra megállni, és megnézni: milyen AI modellek és agent-ek érkeztek meg 2026 elején, illetve mi az, ami már most körvonalazódik. És ami legalább ilyen fontos: vajon ezek a változások tényleg előre visznek minket, vagy csak tovább növelik a zajt?

A 2026 eleji kép egyértelműen azt mutatja, hogy a fókusz eltolódott. Nem „okosabb chatbotokat” építenek, hanem hosszabb ideig dolgozni képes, kontextust tartó, feladatokat elejétől a végéig elvégző modelleket és ügynököket. Ez nem látványos, de nagyon is hasznos irány, amikor egy komplex feladatot szeretnék az AI segítségével elvégezni.

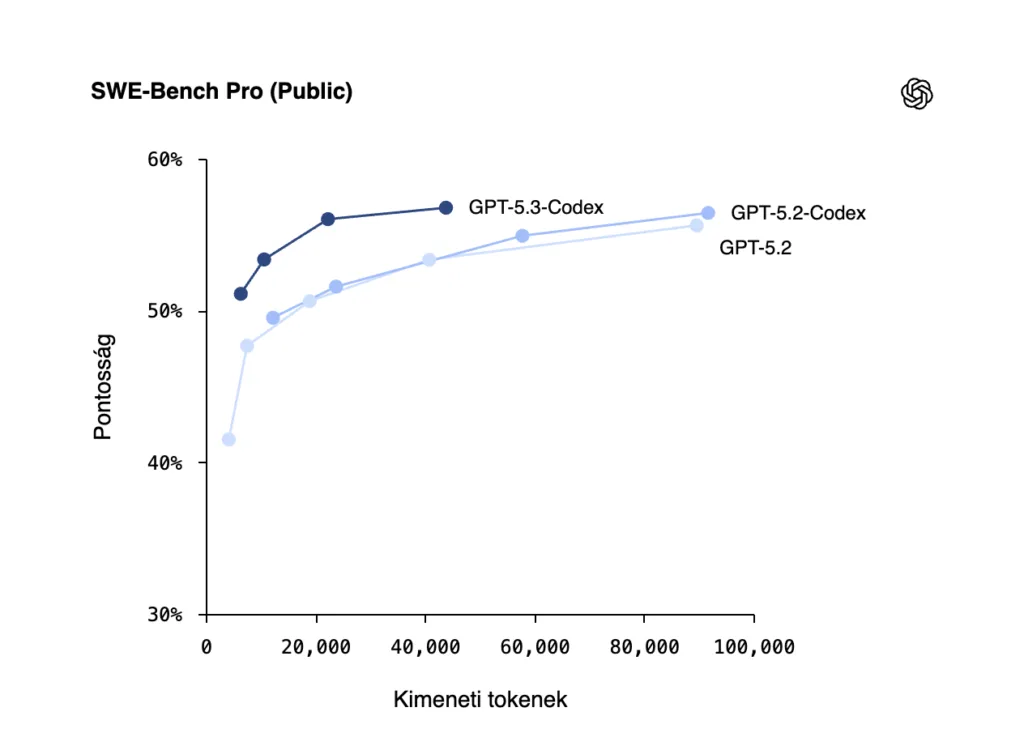

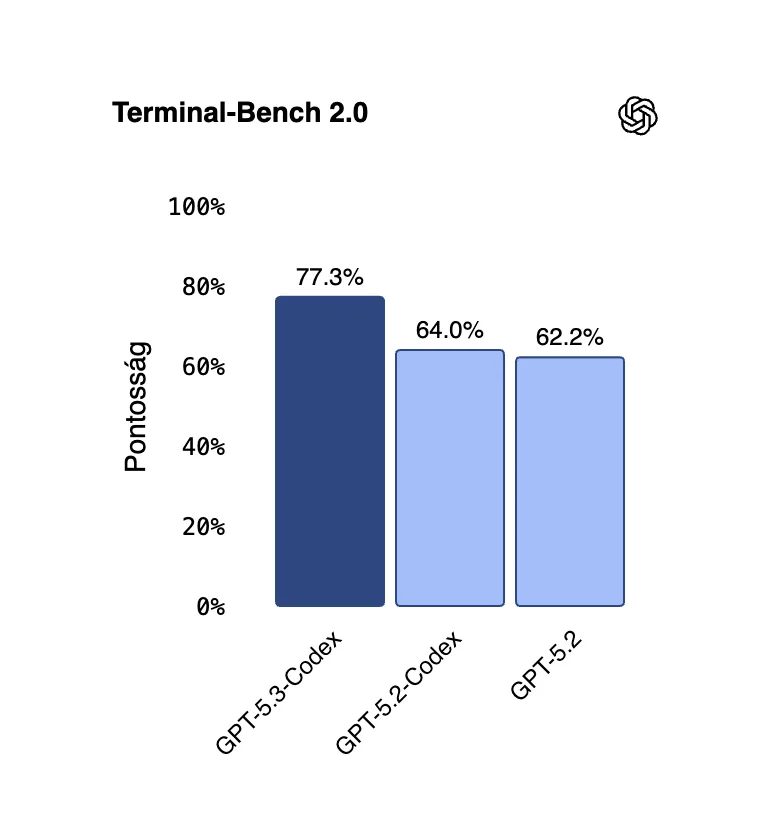

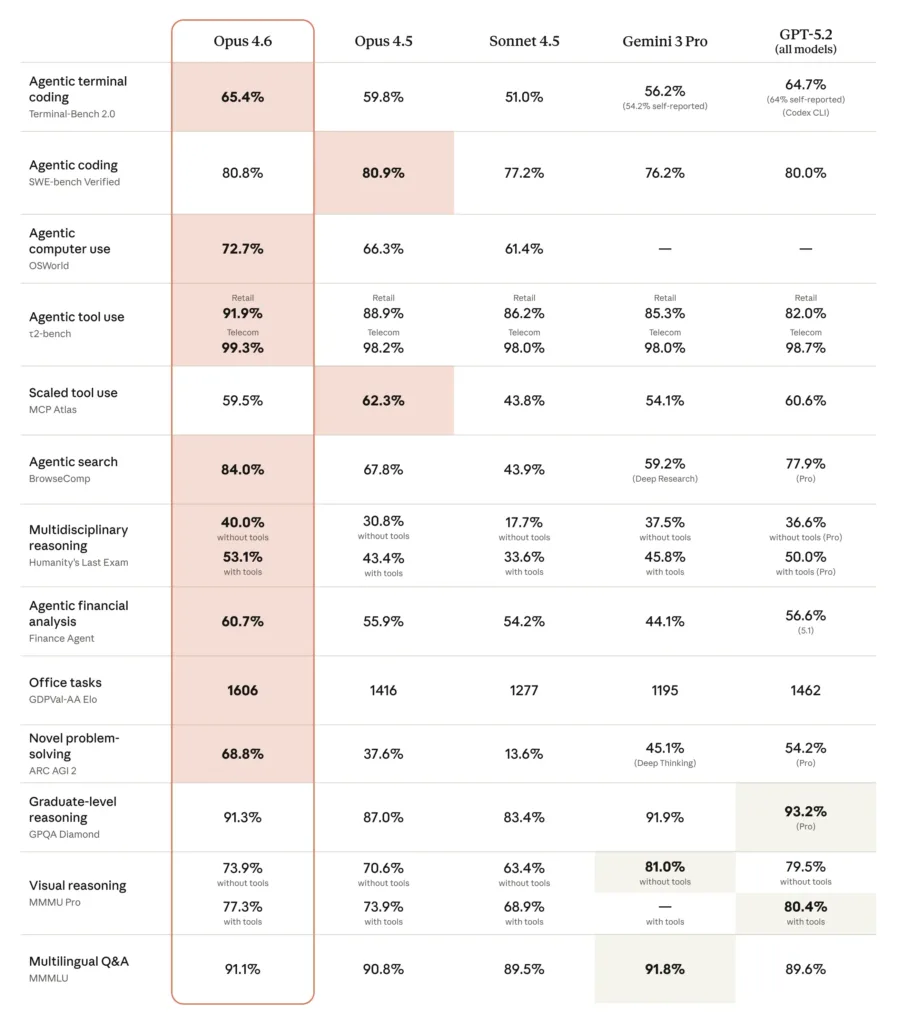

GPT-5.3-Codex – amikor a kódolás már folyamat

A GPT-5.3-Codex február elején jelent meg, és egyértelműen hangsúlyozzák, hogy nem egyszeri promptokra optimalizálták. Az OpenAI itt már kifejezetten agentic codingról beszél: olyan fejlesztési munkáról, amely nem percekig, hanem órákig vagy akár napokig tart.

Ez a modell nem ott erős, hogy „írj egy függvényt”, hanem ott, hogy:

- képes egy komplex kódbázison belül következetesen dolgozni,

- visszatér korábbi döntésekhez,

- és saját hibáit felismerve javítja azokat.

A sebességnövekedés önmagában nem izgalmas. Ami igazán számít: kevesebb beavatkozást igényel. Fejlesztői és DevOps szemmel ez azt jelenti, hogy egyre inkább partnerként viselkedik, nem pedig eszközként.

Ugyanakkor fontos korlát: ez sem váltja ki az architektúrát, a code review-t vagy a felelősségi köröket. Ahol ezt próbálják megspórolni, ott az AI nem segít, hanem megnöveli a hibák számát is.

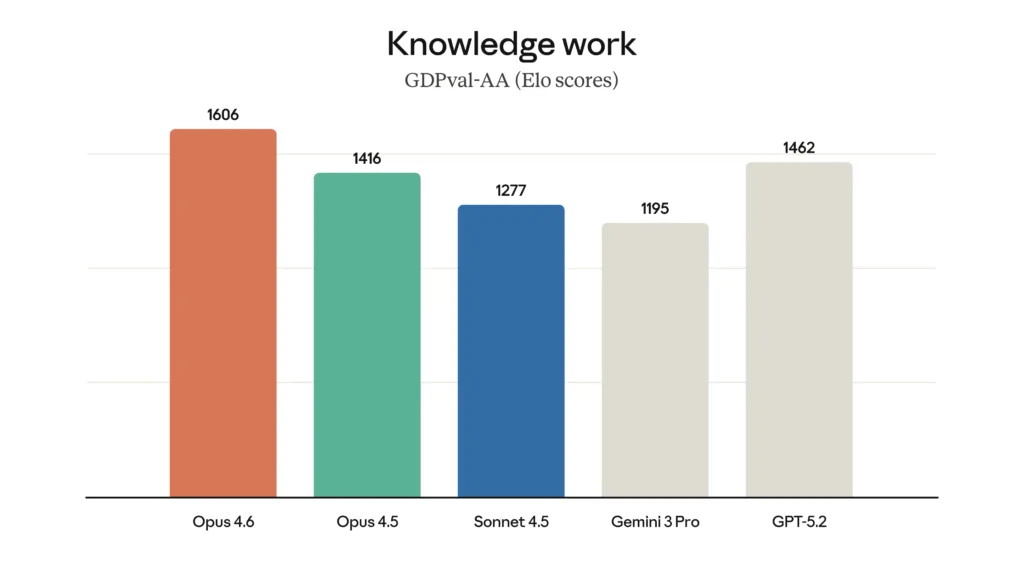

Claude Opus 4.6 – gondolkodás nagy léptékben

A Claude Opus 4.6 szintén február elején jelent meg, de teljesen más problémára ad választ. Itt a hangsúly nem a kódoláson, hanem a tervezésen, elemzésen és hosszú kontextusok kezelésén van.

Ez a modell ott erős, ahol:

- nagy dokumentumhalmazokat kell átlátni,

- összetett üzleti, jogi vagy pénzügyi helyzeteket kell értelmezni,

- vagy több, egymásra épülő döntést kell következetesen végiggondolni.

A hosszú kontextusablak nem öncélú technikai adat. A gyakorlatban azt jelenti, hogy nem kell feldarabolni a problémát csak azért, mert a modell „elfelejt” dolgokat. Ez enterprise környezetben óriási előny.

Cserébe ez nem egy „gyors” modell. Nem ideális real-time interakciókra vagy pipeline-ba illesztett automatikus futtatásra. Inkább döntéstámogató, elemző szerepben erős.

Ennek megfelelően használata drága, amire fel is hívja a figyelmet, amikor ezt a modellt használjuk.

Claude Cowork – amikor az AI tényleg dolgozik

A Claude Cowork nem új modell, hanem egy desktop agent, és emiatt sokkal érdekesebb, mint elsőre tűnik. Ez már nem csak válaszol, hanem:

- fájlokat olvas és szerkeszt,

- mappákban dolgozik,

- böngészőt használ.

Ez az a pont, ahol az AI elkezd beleolvadni a napi munkavégzésbe. Nem külön eszköz, hanem „ott ül melletted”.

Itt viszont nagyon gyorsan előkerülnek a nem technikai kérdések: adatkezelés, jogosultságok, kontroll. Egy ilyen agent hatalmas hatékonyságnövelő lehet, de csak akkor, ha pontosan tudjuk, mit láthat és mit nem. Ez már governance kérdés, nem modellképesség.

A Cowork-nek vannak egyéb különlegességei is, erről majd egy későbbi videóban beszélek nektek.

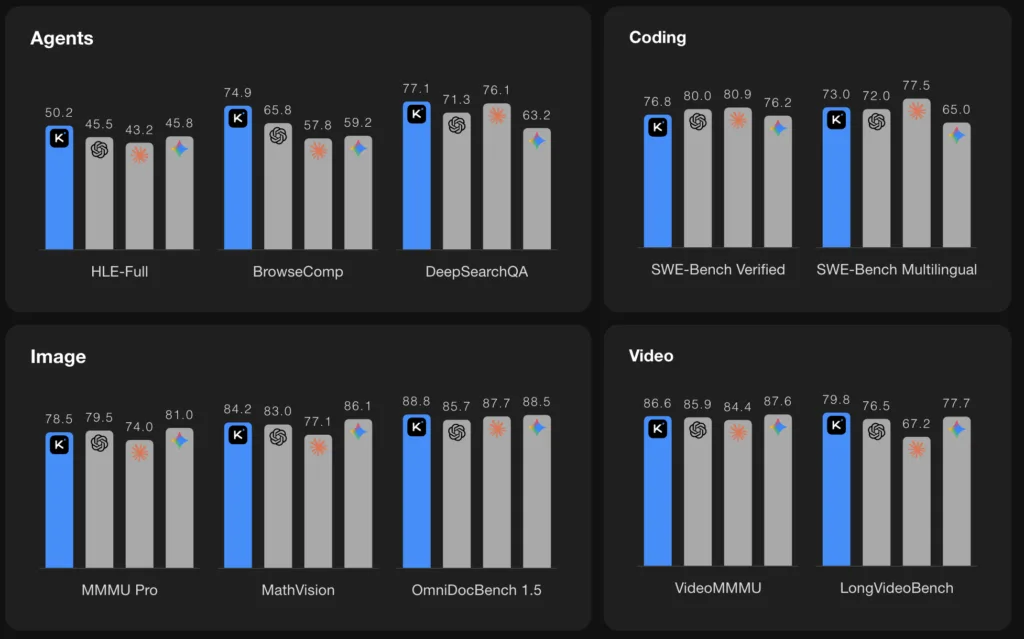

Kimi K2.5 – nyílt AI modell, komoly ambícióval

A Moonshot AI Kimi K2.5 modellje sok benchmarkon jól szerepel, de a lényeg nem ez. Hanem az, hogy nyílt modellként próbál versenyezni a zárt rendszerekkel. Ez már önmagában is izgalmas és ígéretes. Kíváncsi leszek hová jutnak. Én drukkolok nekik.

Multimodális, és az agent-alapú működésre épít: több feladatot képes párhuzamosan kezelni, több „gondolkodási szálon”. Ez különösen érdekes ott, ahol:

- szuverén AI-megoldásokban gondolkodnak,

- on-prem vagy kontrollált környezetben kell futtatni a modellt.

Fontos viszont látni: a nyílt nem jelenti azt, hogy egyszerű. Az üzemeltetés, integráció és finomhangolás továbbra is komoly szakértelmet igényel. Cserébe viszont nagyobb kontrollt ad ,ami sokaknak fontosabb.

Gemma 3 – stabil alap, nem reflektorfényben

A Gemma 3 nem friss februári megjelenés, de 2026 elején is releváns. Ez a modellcsalád nem „mindent megoldó AI”, hanem megbízható építőkocka.

A Gemma ott jó választás, ahol:

- célzott AI-funkciókra van szükség,

- fontos a kiszámíthatóság,

- és nem akarunk egy túl nagy, túl komplex modellt használni.

Sok projektben ez pont elég. Sőt, gyakran jobb, mint egy flagship modell, amit csak részben használunk ki.

Gemini Flash 3 – amikor a sebesség számít

A Gemini Flash 3 2025 decemberében jelent meg, de még bőven frissnek számít. A pozíciója nagyon egyértelmű: gyors, fürge, költséghatékony.

Ez nem a „legmélyebben gondolkodó” modell, hanem az, amelyik:

- jól működik chat-alapú felületeken,

- nagy forgalmat képes kiszolgálni,

- és gyors válaszidőt ad.

A Gemma 3-hoz képest fontos különbség, hogy a Flash 3 inkább kész szolgáltatás, nem építőkocka. Kevesebb döntést igényel, gyorsabban lehet vele funkciót szállítani.

Cserébe nem erre bíznám komplex üzleti logikát vagy mély elemzést. Ott nem ez az erőssége.

Meta: Mango és Avocado – ami még csak irány

A Meta esetében a Mango és Avocado egyelőre belső kódnevek. Amit látni lehet: erős fókusz a multimodalitáson és a skálázhatóságon. Konkrét termékről még nem beszélhetünk, de irányról igen.

Ez tipikusan az a kategória, amit érdemes figyelni, de nem tervezni rá. A Meta eddigi tempóját ismerve lesz folytatás, csak még nem most.

Függetlenül az AI modellektől

A 2026 eleji helyzetkép a szokásos: nem egy „legjobb modell” van, hanem egyre több, jól körülhatárolt szerepre optimalizált megoldás. Ez jó hír, ha tudatosan választunk.

A rossz döntések nem abból születnek, hogy „rossz modellt választunk”, hanem abból, hogy nem tudjuk, mire szeretnénk használni. Ha ezt sikerül kiküszöbölnünk, akkor ezek a modellek és agent-ek valóban előre tudják mozdítani a munkát — technológiailag és üzletileg is.

Ha pedig érdekelnek a hasonló Azure és AI tartalmak:

- Iratkozz fel az InfoPack hírlevélre.

- Kövess LinkedIn-en.

- Iratkozz fel a YouTube csatornámra, ahol rendszeresen jelentkezem új szakmai videókkal.

- És ne feledkezz el megkeresni TikTok-on sem.