Kubernetes namespaces – mert rend a lelke mindennek

Senki sem szereti a rendetlenséget. Akkor sem, ha nem vagyunk rendmániások. Valahol mindannyiunknak szüksége van arra a fajta belső nyugalomra, amit az ad, hogy a dolgok a helyükön vannak. Egy rendezett tér nem csak esztétikai kérdés: segít tisztábban gondolkodni, könnyebben eligazodni, és biztonságérzetet ad a mindennapokban.

Nincs ez másképp a Kubernetes cluster esetében sem. Amikor egyre több alkalmazást, podot, service-t és konfigurációt indítunk el, hamar rájövünk, hogy a rendszer saját “lakói” is igénylik a strukturáltságot. A Kubernetes pedig erre egy elegáns, mégis egyszerű megoldást kínál: a namespace-eket, amelyek láthatatlanul, de nagyon is hatékonyan teremtik meg azt a rendezettséget, amelyre egy növekvő clusternek szüksége van.

Mi az a namespace?

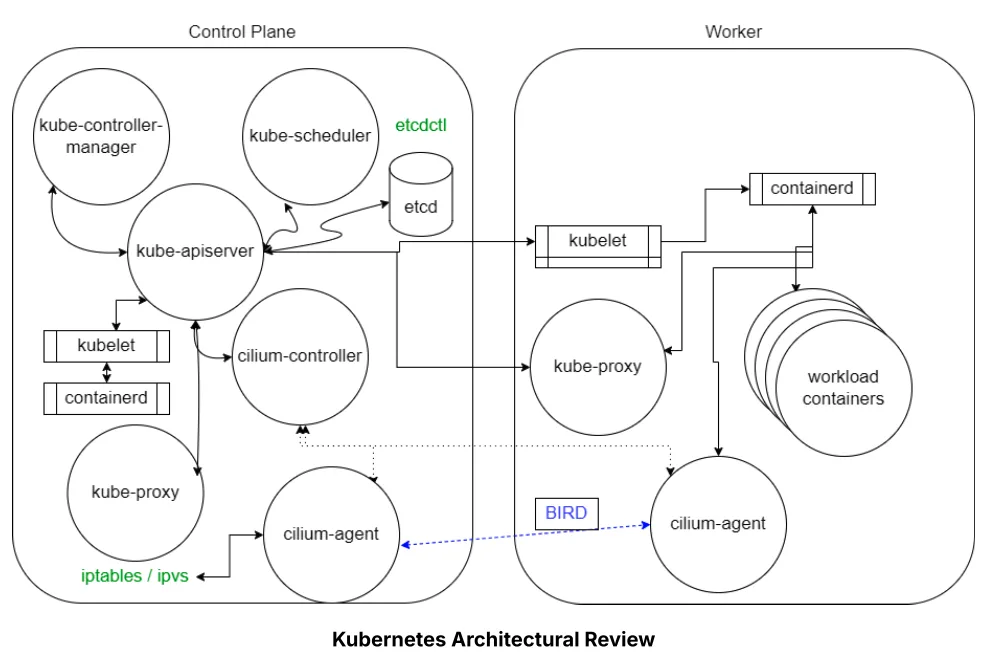

A Kubernetesben a namespace egy logikai szeparációs mechanizmus, amely csoportokra bontja a cluster erőforrásait.

A fogalom eredetileg a Linux kernel világából származik: ott is az izoláció a cél, vagyis hogy különböző folyamatok saját, elkülönített erőforrás-nézetet kapjanak.

A Kubernetes ezt továbbgondolja: a namespace nem csupán technikai elszeparálás, hanem egy szervezési, erőforrás-kontroll és biztonsági keret is.

Lényeg:

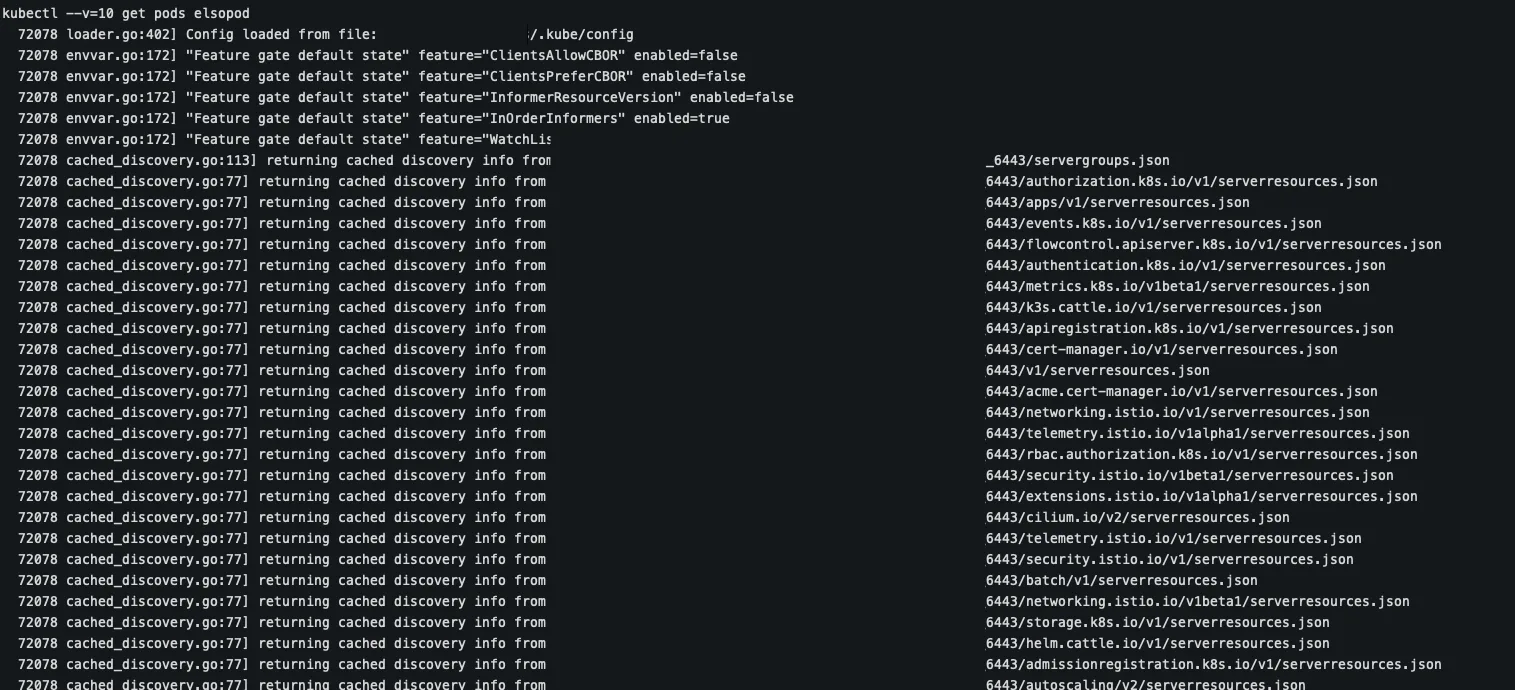

- Minden API-hívás egy namespace-en belül történik, hacsak nem adunk meg külön mást. Például:

https://<api-server>/api/v1/namespaces/default/pods - A namespace lehetővé teszi a kvóták és limitációk alkalmazását egy adott csoport erőforrásaira.

- Később az access control – például RBAC – is működhet namespace-szinten.

- Ha csak néhány erőforrás van a clusterben, akkor a szükségessége nem mindig látszik. De nagyobb vállalati környezetben a namespace az egyik legfontosabb szervezési eszköz.

A Kubernetes alapértelmezett namespace-ei

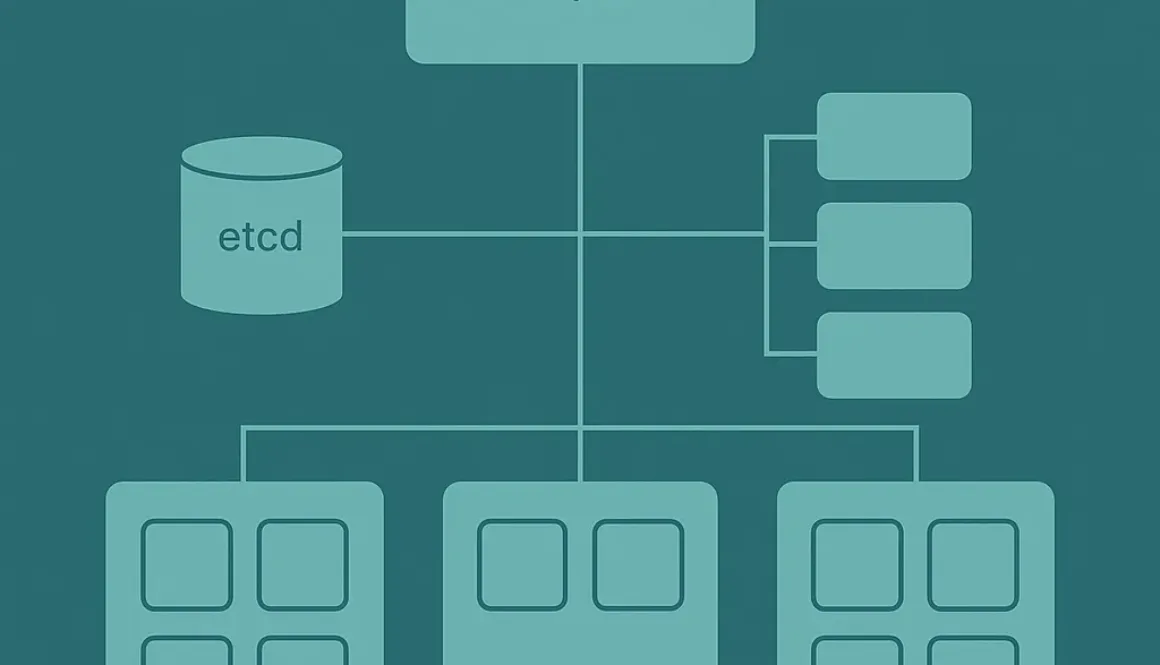

Amikor egy új clustert létrehozunk, Kubernetes négy namespace-t hoz létre automatikusan. Ezek előre definiált szerepet töltenek be, és fontos, hogy ismerjük őket.

default

Az alapértelmezett namespace.

Ha nem adunk meg explicit namespace-t egy API-hívásban vagy egy YAML-ben, minden ide kerül.

kube-system

Itt futnak a rendszer- és infrastruktúra szintű komponensek.

Maga a Kubernetes működéséhez szükséges podok találhatók itt, például a DNS, a kontrollerek, scheduler stb.

kube-public

Ez egy mindenki számára olvasható namespace (még hitelesítetlen felhasználók számára is).

Tipikusan olyan információkat tartalmaz, amelyeknek publikusnak kell lenniük.

kube-node-lease

Ez tárolja a node-ok „lease” objektumait.

A control plane ezzel követi a node egészségi állapotát, gyorsabban és hatékonyabban, mint korábban.

Hogyan dolgozunk namespace-ekkel?

A namespace-ek egy része kimondottan szervezési célokat szolgál: a fejlesztői, tesztelési és éles környezet könnyen elkülöníthető, de akár csapatonként, projektenként vagy üzleti funkcióként is létrehozhatunk új namespace-eket.

A legfontosabb alapműveletek:

Meglévő namespace-ek listázása

kubectl get ns

Új namespace létrehozása

kubectl create ns sajat-projekt

Namespace részletes leírása

Megmutatja többek között a címkéket, annotációkat, kvótákat, limiteket.

kubectl describe ns sajat-projekt

Namespace tartalmának YAML formátumú lekérése

kubectl get ns/sajat-projekt -o yaml

Namespace törlése

kubectl delete ns sajat-projekt

Namespace használata YAML fájlokban

Ha egy erőforrást szeretnénk egy konkrét namespace-ben létrehozni, azt a metadata blokkban kell megadni:

apiVersion: v1

kind: Pod

metadata:

name: redis

namespace: sajat-projekt

Ez a mindennapi Kubernetes fejlesztés egyik alapja: a pod encapsulation, a resource isolation és a cluster szervezése így lesz konzisztens, rendezett és biztonságos.

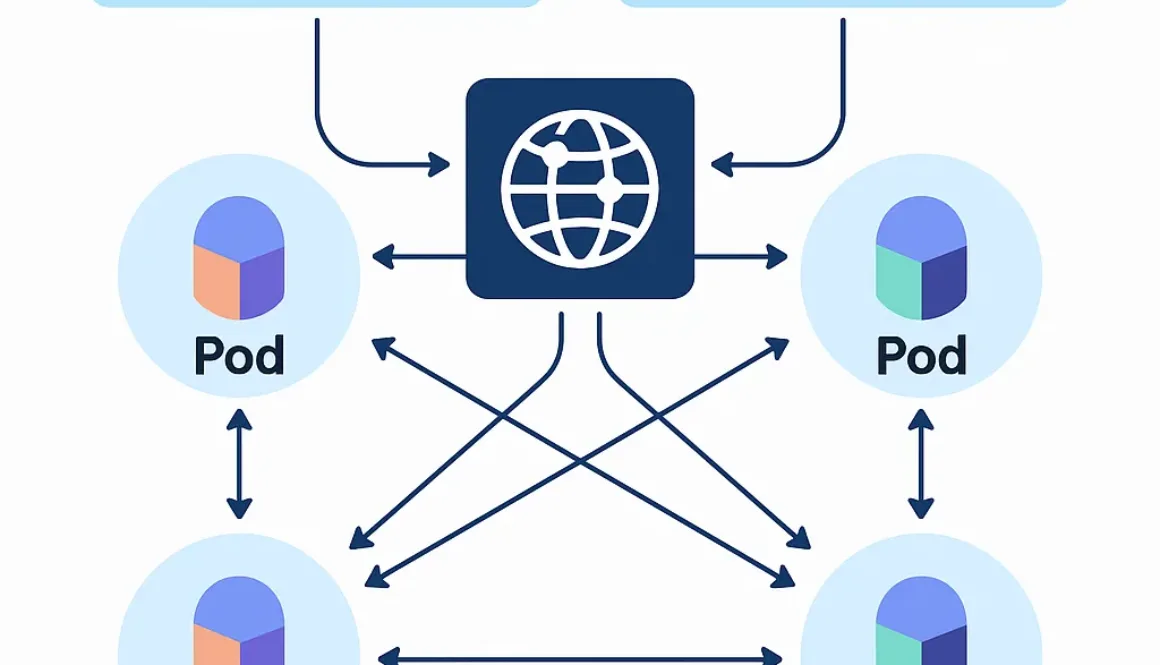

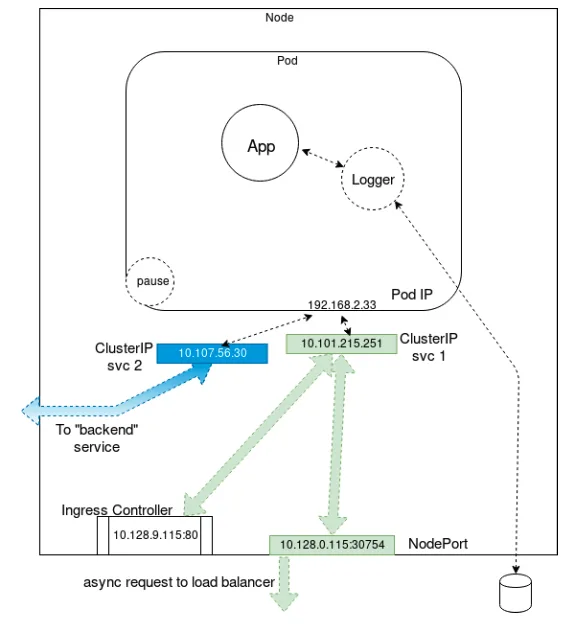

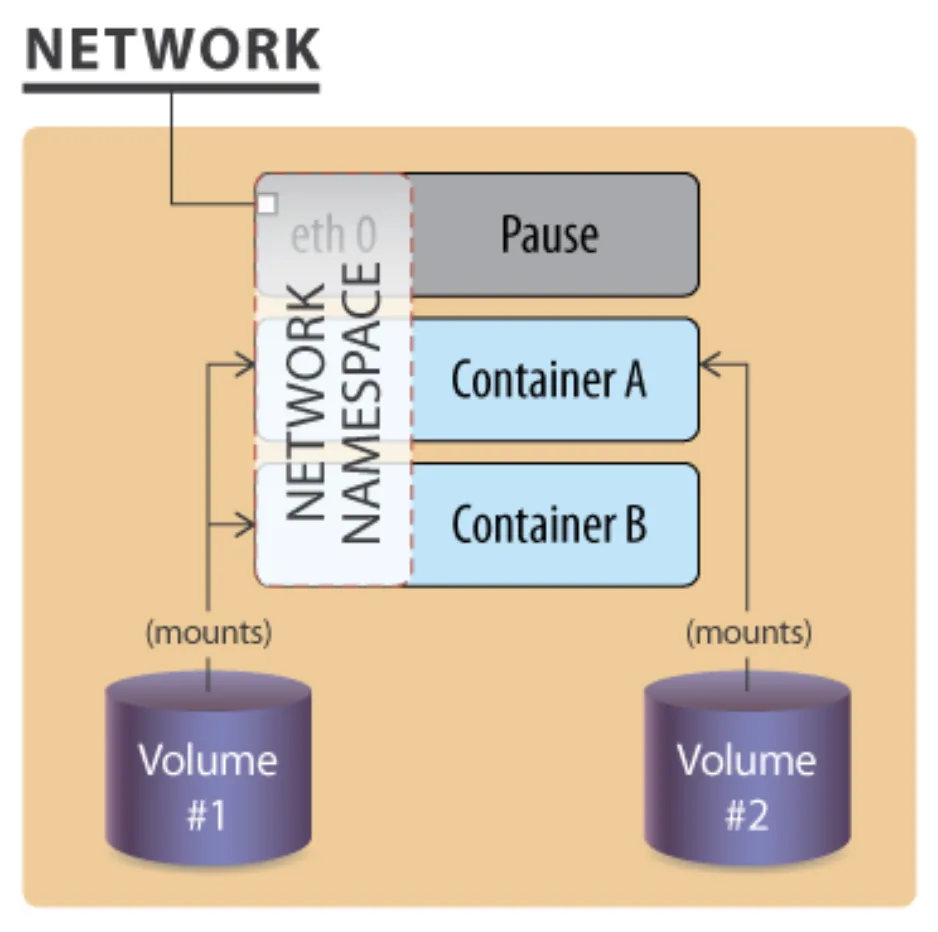

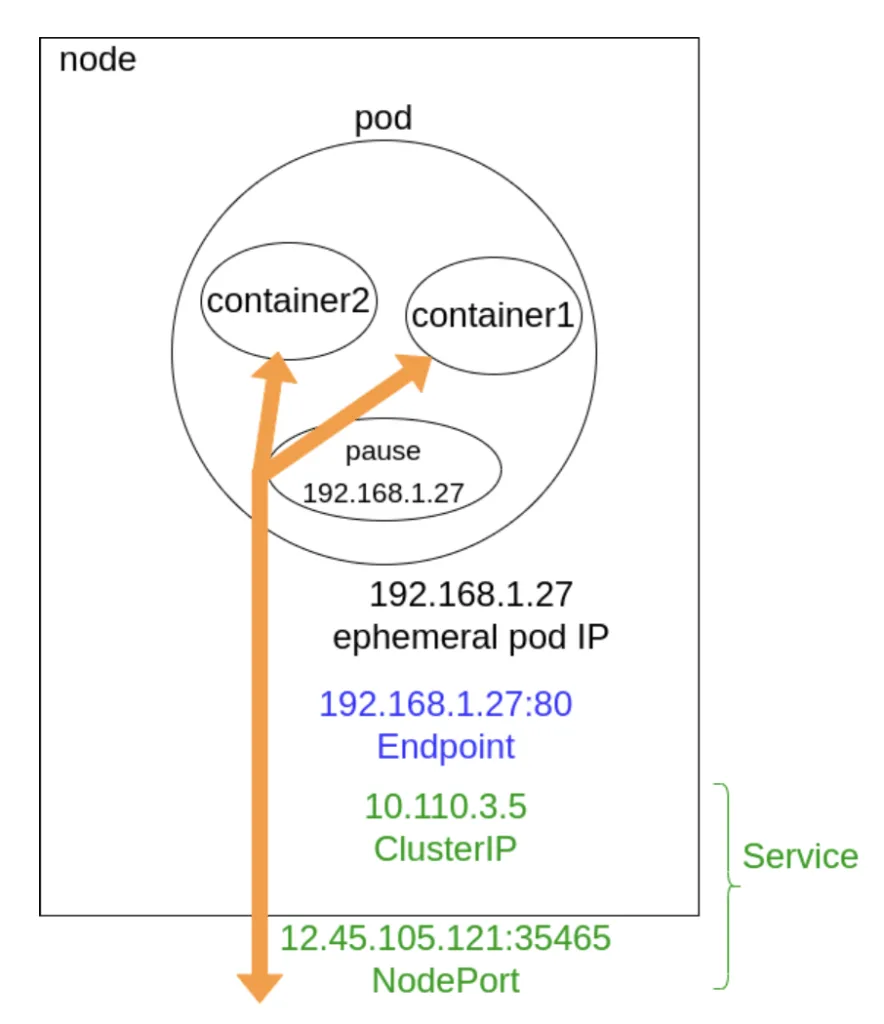

pod encapsulation: A „pod-beágyazás” azt jelenti, hogy a Kubernetes egyetlen kezelhető egységbe, az úgynevezett Podba foglal egy vagy több szorosan együttműködő konténert, a közösen használt tárolót és hálózati erőforrásokat. Ez lehetővé teszi, hogy konténerek egységes egészként működjenek: közösen használják az olyan erőforrásokat, mint a tároló vagy a hálózat, miközben a rendszer egy csomóponton (node) együtt ütemezi és kezeli őket. Ez a megközelítés jelentősen leegyszerűsíti az alkalmazások telepítését és skálázását.

Mikor érdemes namespace-t használni?

A namespace akkor segít igazán, ha:

- több csapat dolgozik ugyanabban a clusterben,

- több környezetet szeretnénk egymástól elszeparálni (dev, test, staging, prod),

- erőforráskvótákat kell alkalmazni (CPU, memória, storage),

- korlátozni akarjuk az erőforrások láthatóságát vagy módosíthatóságát,

- strukturált, átlátható cluster felépítést szeretnénk.

Kisebb clusterben nem mindig tűnik létkérdésnek, de hosszú távon a namespace az egyik legfontosabb szervezési eszköz, ami segít megelőzni a káoszt.

Összegzés

A namespace látszólag egy apró részlet a Kubernetesben, mégis az egész ökoszisztéma egyik legfontosabb alapköve.

Rendet teremt, felelősségi köröket választ szét, erőforrásokat szabályoz, és előkészíti a terepet a biztonságos, skálázható működéshez.

Ahogy tovább haladunk a Kubernetes mélyebb rétegei felé, újabb olyan elemeket fogunk megismerni, amelyek pontosan ilyen csendben, mégis hatalmas erővel segítik a fejlesztőket, üzemeltetőket és szervezeteket abban, hogy a microservice-ek világában stabil rendszereket építsenek.