RAG és CAG: a pontosság vagy a sebesség az AI jövője?

A generatív mesterséges intelligencia világában már nem csak az számít, milyen nagy egy modell vagy hány milliárd paramétere van. Az is legalább ennyire fontos, hogyan tudjuk kiegészíteni és finomítani a modell működését. Korábban írtam a Retrieval-Augmented Generation (RAG) működéséről és előnyeiről. Most egy viszonylag új, de egyre nagyobb figyelmet kapó megközelítésről írok: ez a Cache-Augmented Generation (CAG).

Ebben a cikkben bemutatom, mit jelent a CAG, hogyan működik, miben más, mint a RAG, és mikor érdemes egyik vagy másik módszert választani.

Hogyan jutottunk el a RAG-tól a CAG-ig?

Amikor a nagy nyelvi modellek (LLM-ek) elterjedtek, hamar kiderült, hogy zárt tudású modellekkel nem tudjuk tartani a lépést a világ gyorsan változó információival. Ez hívta életre a RAG koncepcióját, ahol a modell a válasz előtt külső forrásokból (pl. céges dokumentumtárból, tudásbázisból) keres információt, és ezt beemeli a generálásba.

A RAG tehát egyfajta „keresés + válasz” kombinációt jelentett.

Később azonban új kihívások merültek fel:

- nőtt a felhasználói igény a valós idejű válaszadásra,

- sok rendszerben ismétlődő kérdések jelentkeztek,

- és a RAG-es lekérdezések nem mindig voltak költséghatékonyak.

Ez vezetett el a Cache-Augmented Generation (CAG) gondolatához: ha egyszer már válaszoltunk valamire, miért ne tárolnánk el?

Mi az a Cache-Augmented Generation (CAG)?

A CAG lényege, hogy a generatív modell működését nem külső dokumentumokkal támogatjuk meg (mint a RAG esetén), hanem egy belső gyorsítótárra (cache) építünk, amely korábbi válaszokat vagy tudáselemeket tárol. Ez a cache lehet előre feltöltött (pl. sablonos kérdésekre adott válaszokkal), vagy dinamikusan épülhet ki a felhasználók aktivitása alapján.

A CAG technikai alapjai – amit érdemes tudni

A modern CAG-rendszerek több trükköt is bevetnek a hatékonyság növeléséhez:

- Előzetes betöltés (Preloading) a kontextusablakba – a modell „látóterébe” már előre bekerül a fontos tudásanyag.

- KV-cache (Key-Value Cache) – a modell tárolja a korábban generált tokenekhez tartozó rejtett állapotokat, így újrahasznosíthatók.

- Hasonlóság-alapú visszakeresés – a rendszer nemcsak azonos promptokra reagál, hanem felismeri a jelentésbeli hasonlóságokat is.

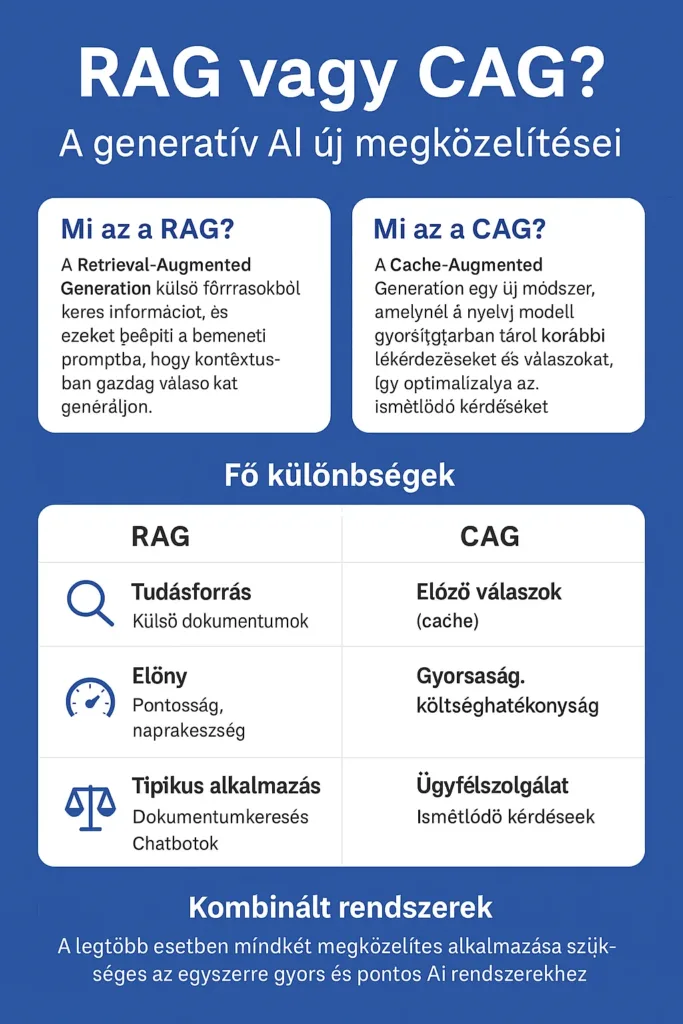

Hogyan különbözik a CAG a RAG-től?

A RAG működéséhez elengedhetetlen egy jól strukturált tudásbázis. A modell először lekérdezi a számára releváns dokumentumokat, majd ezek alapján alkot választ. Ezzel szemben a CAG nem keres semmit, hanem a saját „emlékezetére” támaszkodik.

| Szempont | RAG | CAG |

|---|---|---|

| Tudásforrás | Külső (pl. dokumentumok, adatbázis) | Belső (cache, előre betöltött tudás) |

| Teljesítmény (sebesség) | Lassabb a keresés miatt | Nagyon gyors, különösen ismétlődő kérdésekre |

| Erőforrásigény | Magasabb | Alacsonyabb |

| Pontosság friss információnál | Magas (aktuális tudás elérhető) | Korlátozott (nincs frissítés automatikusan) |

| Ideális alkalmazás | Dokumentumkereső, intelligens asszisztens | Ügyfélszolgálat, chatbot, sablonos válaszok |

Valós példák RAG és CAG alkalmazásra

RAG példa:

Képzeld el, hogy van egy cég belső dokumentumtára, ahol a HR, pénzügy és IT leírások PDF-ben elérhetők. Ha egy dolgozó megkérdezi: „Hány nap szabadság jár 3 év munkaviszony után?”, a RAG-alapú asszisztens lekérdezi a vonatkozó HR-dokumentumot, beemeli a szövegbe, és ennek alapján ad választ.

CAG példa:

Ugyanez a dolgozó hetente ötször kérdezi meg: „Hogyan tudom megváltoztatni a jelszavam?” – a rendszer ezt a kérdést egyszer már megválaszolta. A CAG gyorsítótára felismeri az ismétlődést, és azonnal visszaadja a korábbi választ, teljes generálás nélkül.

RAG + CAG együtt

Egy ideig úgy tekintettünk a RAG és a CAG módszerekre, mint egymással versengő megoldásokra. Én viszont azt tapasztalom, hogy nem kizárják, hanem épp kiegészítik egymást.

Egy modern AI rendszer például működhet így:

- Első lépés: a rendszer megvizsgálja, van-e releváns találat a cache-ben (CAG).

- Ha nincs megfelelő találat, akkor lekérdez egy külső tudásbázist (RAG) és generál egy új választ.

- Ez az új válasz eltárolódik a cache-ben, így legközelebb már gyorsabban és olcsóbban elérhető.

Ez a lépcsőzetes logika optimalizálja az erőforrás-használatot, miközben nem mond le sem a sebességről, sem a pontosságról.

Én úgy látom, hogy a jövő generatív rendszerei ezt a kettős stratégiát fogják követni: a CAG biztosítja a gyorsaságot és kiszámíthatóságot, míg a RAG gondoskodik a mély, megalapozott válaszokról. A kettő együtt nemcsak hatékonyabbá teszi a rendszert, hanem javítja a felhasználói élményt is.

Mely AI modellek használják ezeket?

- RAG-et használ:

- OpenAI GPT + retrieveres példák (pl. ChatGPT Enterprise tudásbázis integráció)

- Meta által közzétett RAG architektúrák (RAG-Sequence, RAG-Token)

- Bing Chat, Perplexity AI

- LangChain-alapú RAG-pipelinek

- CAG-et alkalmaz:

- Mistral nyílt forrású LLM-ek kontextusablakos gyors betöltéssel

- GPT-4 Turbo – optimalizált KV-cache rendszerrel működik, nagy prompt ismétlések esetén gyorsabb válasz

- Claude 3 (Anthropic) – cache-szerű belső rejtett állapotkezelést használ kontextuson belül

- Egyes cégek saját implementációi (pl. HelpDesk-rendszerek belső cache-sel)

Összefoglalás

A CAG nem egy újabb buzzword – hanem egy valódi válasz a generatív AI rendszerek skálázhatósági és sebességbeli kihívásaira. A RAG továbbra is verhetetlen, ha friss, kontextusban gazdag válaszokra van szükség. A CAG viszont ott nyer, ahol gyorsaság, egyszerűség és alacsony költség a cél.

Én egyre gyakrabban építek be CAG-alapú logikát a prototípusaimba, főleg akkor, ha nagy felhasználószámra kell tervezni. Ha pedig RAG-re van szükség, már tudom, mikor és hogyan érdemes bevetni.

A jövő generatív rendszerei nem választanak egyet a kettő közül – hanem dinamikusan kombinálják őket.